File robots.txt là gì? Tại sao cần phải có file robots.txt, nó ảnh hưởng gì tới SEO không, làm thế nào để tạo file robots.txt trên WordPress chuẩn nhất. Cùng Blog tuicocach.com tìm hiểu trong bài viết dưới đây.

File robots.txt là gì? Tại sao cần phải có file robots.txt

File robots.txt đơn giản cũng chỉ là một file text thông thường, nhưng nó có nhiệm vụ khai báo cho các trình thu thập dữ liệu(Googlebot, Bingbot...) về những trang nào được phép thu thập dữ liệu, trang nào thì không(Tức là chặn một thư mục hoặc trang nào đó đối với các con bot thu thập dữ liệu).

Mặc định các trình thu thập dữ liệu vẫn sẽ quét nội dung website kể cả khi không có tùy chỉnh file robots.txt. Tuy nhiên sẽ không đạt hiểu quả cao, do bots sẽ thu thập toàn bộ nội dung của trang web, có những thứ không cần phải quét như plugin đang dùng, các thư viện nội dung không muốn hiển thị trên kết quả tìm kiếm.

Đặt file robots.txt ở đâu trên WordPress

Khi tạo website WordPress, nó sẽ tự động tạo ra một file robots.txt đặt ngay bên dưới thư mục gốc(tức ngang hàng với wp-include, wp-admin, wp-config.php…), nếu chưa có chúng ta có thể tạo mới file này.

Kiếm tiền Accesstrade, kiếm tiền tại nhà với Accesstrade.vn – Tiếp thị liên kết

MegaURL – Rút gọn link kiếm tiền có giá cao tại Việt Nam

Top những App kiếm tiền online trên điện thoại tốt nhất hiện nay

Với những website không sử dụng wordpress cũng chỉ cần tạo và đặt file này ngay tại thư mục gốc là được nha.

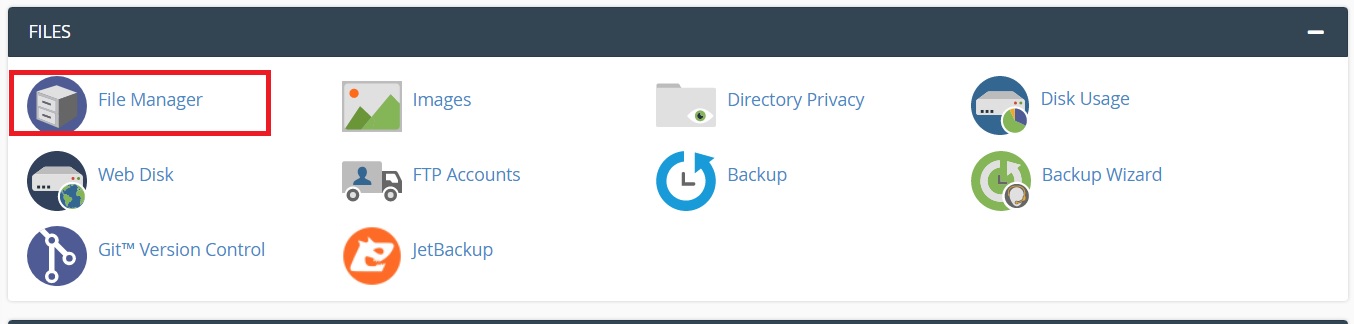

Để mở được thư mục chứa mã nguồn(thư mục gốc của website) trên Hosting bằng cPanel, bạn đăng nhập vào cPanel.

Trong bảng điều khiển cPanel, bạn mở mục File Manager như hình bên dưới.

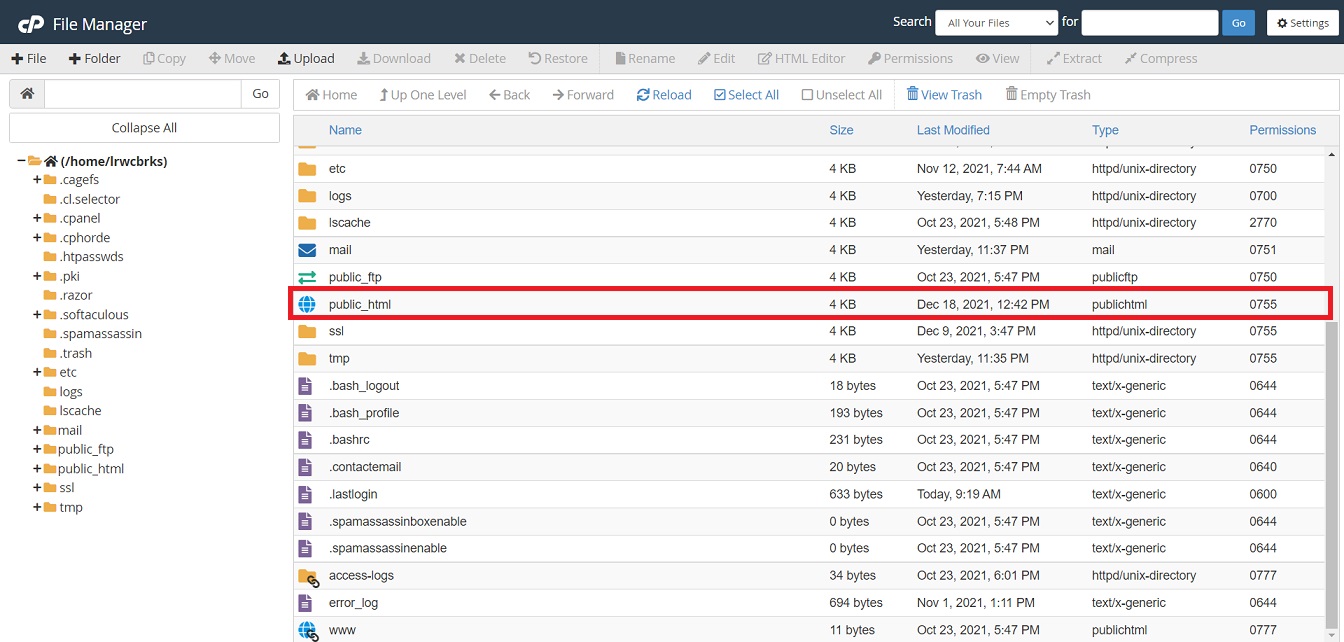

Tiếp tục chọn mở thư mục tên là public_html hoặc là htdocs, mã nguồn website sẽ được đặt tại thư mục này.

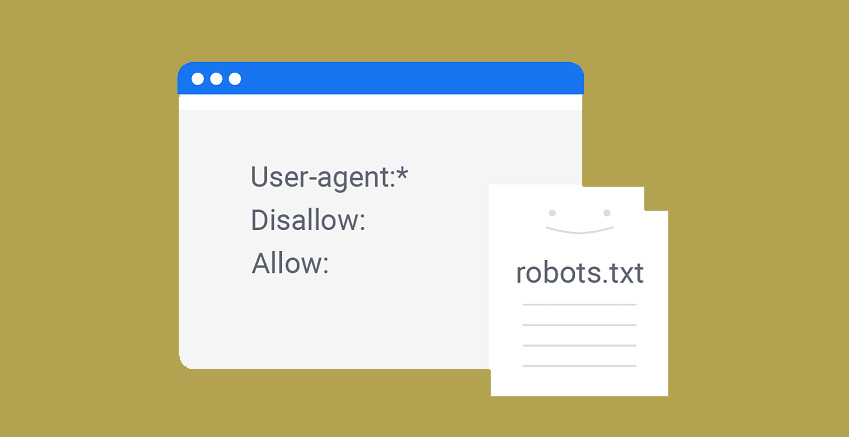

Cú pháp của file robots.txt

Các cú pháp được xem là ngôn ngữ riêng của các tập tin robots.txt. Có 5 thuật ngữ phổ biến sẽ bắt gặp trong một file robots.txt. Chúng bao gồm:

- User-agent: Phần này là tên của các trình thu thập, truy cập dữ liệu web. (ví dụ: Googlebot, Bingbot,…)

- Disallow: Được sử dụng để thông báo cho các User-agent không thu thập bất kì dữ liệu URL cụ thể nào. Mỗi URL chỉ được sử dụng 1 dòng Disallow.

- Allow (chỉ áp dụng cho bọ tìm kiếm Googlebot): Lệnh thực hiện thông báo cho Googlebot rằng nó sẽ truy cập một trang hoặc thư mục con. Mặc dù các trang hoặc các thư mục con của nó có thể không được phép.

- Crawl-delay: Thông báo cho các Web Crawler biết rằng nó phải đợi bao nhiêu giây trước khi tải và thu thập nội dung của trang. Tuy nhiên, lưu ý rằng bọ tìm kiếm Googlebot không thừa nhận lệnh này. Bạn cài đặt tốc độ thu thập dữ liệu trong Google Search Console.

- Sitemap: Được sử dụng để cung cấp các vị trí của bất kì Sitemap XML nào được liên kết với URL này. Lưu ý lệnh này chỉ được hỗ trợ bởi công cụ Google, Ask, Bing và Yahoo.

Định dạng file robots.txt chuẩn và cơ bản nhất WordPress

Định dạng cho một file robots.txt chuẩn và cơ bản nhất như bên dưới, với http://example.com là tên miền website của bạn.

User-agent: * Disallow: /wp-admin/ Allow: / Sitemap: http://example.com/sitemap_index.xml

Giải thích ý nghĩa:

User-agent: * : dấu * có nghĩa khai báo bao gồm tất cả những trình thu thập.

Disallow: /wp-admin/ : Không cho phép các trình thu thập dữ liệu, thu thập dữ liệu nằm trong thư mục wp-admin

Allow: /: Cho phép Googlebot thu thập tất cả dữ liệu trên website, ngoại trừ thư mục wp_admin đã bị chặn ở trên.

Sitemap: http://www.example.com/sitemap_index.xml: Phần này gọi là khai báo sơ đồ trang web. Nếu bạn chưa biết sitemap là gì, và cách tạo hãy đọc bài viết này: https://tuicocach.com/sitemap-la-gi-cach-tao-sitemap-trong-wordpess/

Định dạng file robots.txt mình đang dùng trên blog này

Định dạng file robots.txt mình đang dùng cho blog này có cấu trúc như bên dưới.

User-agent: * Disallow: /wp-admin/ Disallow: /readme.html Disallow: /license.txt Disallow: /wp-content/plugins Disallow: /cgi-bin/ Allow: /wp-admin/admin-ajax.php Allow: /wp-admin/images/* Allow: /wp-content/plugins/td-standard-pack Sitemap: https://tuicocach.com/sitemap_index.xml Sitemap: https://tuicocach.com/post-sitemap.xml Sitemap: https://tuicocach.com/post_tag-sitemap.xml Sitemap: https://tuicocach.com/category-sitemap.xml Sitemap: https://tuicocach.com/page-sitemap.xml

Tại sao mình lại sử dụng định dạng này:

Đối với các trang wp-admin, thư mục cgi-bin và các file readme.html, license.txt theo mình thì không cần thiết và không nên cho các con bots thu thập và lập chỉ mục với những trang này nên mình đã chặn lại.

Với các Blugin mình cũng để Disallow, việc thu thập dữ liệu từ các blugin cũng là không cần thiết. Ngược lại, nếu chúng ta cho phép thu thập dữ liệu từ các blugin thì mỗi lần các con bots tiến hành kiểm tra và thu thập dữ liệu nó sẽ trở thành một loại tài nguyên chặn hiển thị. Tức là, nó làm tăng lưu lượng và thời gian tải trang lên, dẫn tới việc một số tài nguyên quan trọng như css của theme không thể tải. Từ đó, website có thể bị tình trạng "Không tương thích thiết bị di động" đối với Googlebot.

Ngoại trừ blugin td-standard-pack, blugin này có ảnh hưởng tới việc hiển thị của giao diện trên blog của mình nên mình sẽ cho phép thu thập dữ liệu từ blguin này.

Lý do gì mình lại khai báo quá nhiều sitemap như vậy?. Với sitemap_index.xml là sitemap chính, các sitemap khác chỉ là từng nhánh nhỏ, tuy nhiên khi khai báo sitemap mình thấy một số bots không thể đọc hết được các đường dẫn từ sitemap_index.xml nên mình đã khai báo thêm các sitemap nhánh này.

Cảm ơn bạn đã đọc hết bài viết, bài viết này còn nhiều chỗ trình bày lan man bạn còn thắc mắc hay góp ý cho mình thì comment bên dưới để mình biết nhé.

Bình luận